stable diffusion

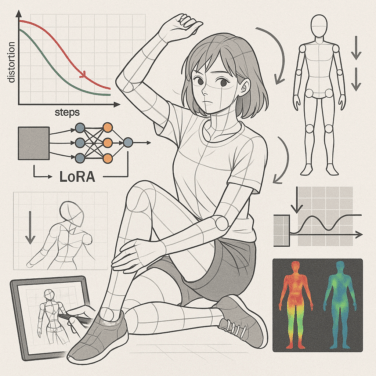

stable diffusionStable DiffusionのLoRAトレーニングでLoss値にこだわらなくていい理由

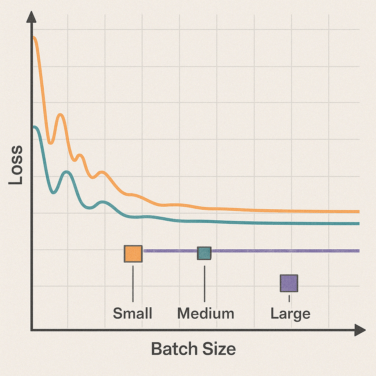

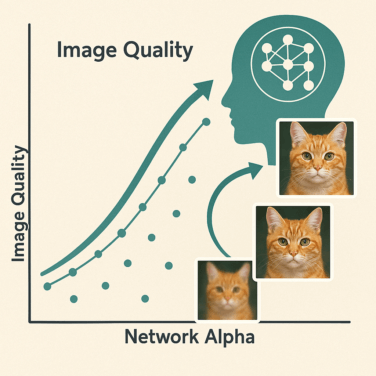

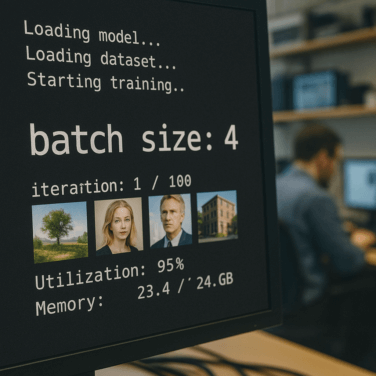

Stable Diffusionを使って自分だけのLoRAモデルを作成する際、トレーニング過程で表示されるLoss値(損失値)について「あまり気にしなくていい」という情報を目にすることがあります。一般的な機械学習では、Loss値の...

stable diffusion

stable diffusion stable diffusion

stable diffusion stable diffusion

stable diffusion stable diffusion

stable diffusion stable diffusion

stable diffusion stable diffusion

stable diffusion stable diffusion

stable diffusion 生成AI

生成AI stable diffusion

stable diffusion 生成AI

生成AI stable diffusion

stable diffusion stable diffusion

stable diffusion stable diffusion

stable diffusion stable diffusion

stable diffusion stable diffusion

stable diffusion stable diffusion

stable diffusion stable diffusion

stable diffusion